P.S. zum Brief an einen Freund in der Corona-Krise

P.S. zum Brief an einen Freund in der Corona-Krise

Angesichts der explodierenden Fülle von Corona-bezogenen Artikeln in allen Medien - wie kann man da relevante von irrelevanten bis hin zu gezielt irreführenden „Beiträgen“, wie kann man Wahrheit von Unsinn und Unwahrheit unterscheiden? Das kann sehr mühsam sein: Um einer systematischen Unterscheidung willen müsste man die Artikel erstens lesen, zweitens ihre Relevanz untersuchen und sich drittens in vielen Fällen auch noch intensiv mit den Inhalten auseinander setzen. Das kostet Zeit, bringt selten bedeutsame Erkenntnis und erzeugt am Ende oft nur Ärger und Frustration. Ich selbst habe es deshalb aufgegeben, mich mit der Informationsflut zu befassen, mit der die Medien (und meine Mailbox) täglich überschwemmt werden. Dass dabei dann auch kluge, lesenswerte Beiträge ungelesen bleiben, das nehme ich in Kauf. Meine reale Informationsquelle sind die Zeitungen und Zeitschriften, von deren Solidität und Unabhängigkeit ich mich in vielen Jahren überzeugen konnte. Dass auch in diesen Organen die inhaltliche oder redaktionelle Qualität der Beiträge bisweilen drittklassig ist, auch das nehme ich in Kauf.

Mir ist im übrigen sehr bewusst, wie privilegiert ich als Wissenschafter bin: Als langjähriges Mitglied im Vorstand des Kuratoriums der Wissenschaftspressekonferenz (WPK) habe ich großes Vertrauen in die Arbeit der WPK-Mitglieder. Meine wichtigste Informationsquelle sind und bleiben schließlich die vielen hoch qualifizierten Kollegen aus allen Fakultäten, die ich im Laufe meiner wissenschaftlichen Arbeit und als Forschungsmanager kennengelernt habe. Diese Kollegen kann ich jederzeit ansprechen oder anrufen, wenn ich selbst im Zweifel bin oder Fragen habe.

Offener Brief an einen Freund in der Corona-Krise

Lieber Freund,

die Corona-Krise hat uns voneinander entfernt. Du hast, gleich nachdem Bund und Länder die harten Maßnahmen des Social Distancing und des Shutdown beschlossen hatten, gegen die Maßnahmen protestiert und zum öffentlichen Protest (auf Deiner Webseite) aufgerufen. Es war für Dich klar und Du hast von mir erwartet, dass ich - als Mathematiker - Dich in Deinen Bemühungen, den Protest öffentlich zu machen, unterstützen würde.

Für mich war die Sache so einfach nicht. Auch ich war über manche der öffentlichen Äußerungen von Experten und Politikern in Talkshows und auf Pressekonferenzen bisweilen irritiert. Die Gefährlichkeit des Virus wurde z.B. oft durch Zahlen und Kurven belegt, die ich als Mathematiker für unverständlich und irreführend halte. Von Beginn der Krise an war die Datenbasis unzureichend und unübersichtlich und die Statistik infolgedessen äußerst fragwürdig; die Interpretation des Zahlenmaterials durch die Medien erschien mir bisweilen durchaus willkürlich. (Einige der Fragen, die sich mir stellten, habe ich schon an anderer Stelle veröffentlicht.) Trotz dieser Fragen hatte ich nie Zweifel an der unbestreitbar hohen Kompetenz der erstklassigen Experten, über die wir in Deutschland verfügen. Einige kenne ich auch persönlich; sie geben ohne Zweifel ihr bestes, um die Situation realistisch einzuschätzen und die aktuellen Probleme zu bewältigen. Dass es auch unter Experten immer mal wieder Selbstdarsteller gibt, denen ihr Auftritt und ihre Wirkung wichtiger ist als die Sache - das ist nun einmal leider so. Insgesamt war und bin ich aber überzeugt, dass wir mit unseren Experten höchst zufrieden sein können.

Dass die von der Bundesregierung und den Ländern getroffenen Maßnahmen hart waren, was die Wirtschaft, die Arbeitswelt, die Gesellschaft als Ganzes, das öffentliche und das private, familiäre Leben angeht, ist auch unbestreitbar. Und dass gerade jetzt, wo es um eine vorsichtige Öffnung geht, manche Einzelentscheidungen schwer zu verstehen und fragwürdig sind, auch das kann ich den Kritikern gern zugestehen. Aber dass unser Rechtsstaat bedroht sei und die Gefahr bestünde, einige unserer grundgesetzlich garantierten Rechte könnten uns auf Dauer abhanden kommen - das sehe ich überhaupt nicht. Jeder Verantwortliche weiß, dass wir uns in einer extremen Ausnahmesituation befinden und dass die Maßnahmen nur durch diese Ausnahmesituation gerechtfertigt sind. Einzelne Maßnahmen können trotzdem grundsätzlich oder praktisch falsch sein; und es kann dringend erforderlich sein, solche problematischen Maßnahmen nachträglich einer juristischen oder parlamentarischen Kontrolle zu unterziehen.

Während die Gefährlichkeit der Pandemie und die Angemessenheit der Maßnahmen in vielen Bereichen noch diskutabel sein mögen - bei den meisten der absurden Gerüchte und abwegigen Verschwörungstheorien, mit denen die Öffentlichkeit seit Wochen überschüttet wird, hört für mich jede Toleranz auf. Besonders empören mich die Darstellungen im Internet, die von angeblichen Experten in einer Weise verbreitet werden, dass der Laie kaum eine Chance hat, sie von fundierten Aussagen kompetenter Experten zu unterscheiden. Und ich kann auch solche Plattformen nicht akzeptieren, die sich "offen" geben und zwischen relevanten und subtil diffamierenden Beiträgen nicht differenzieren. Solchen Diffamierungen sind manche untadeligen, hochkompetenten Wissenschaftler (wie z.B. Christian Drosten) und weltweit engagierte Philanthropen (wie Bill Gates) ausgesetzt. Unerträglich.

Es ist mir wichtig, Dir meine Sicht der Dinge zu erklären. Ich sehe mich als Wissenschaftler der Wahrheit verpflichtet. Dabei ist mir bewusst, dass Wahrheit ein großes Wort ist und die Wahrheit oft schwer zu erkennen ist. Aber wo man die Unwahrheit kennt oder erkannt hat, gibt es keine Rechtfertigung, sie zu verbreiten.

Ich weiß, dass wir uns beide der Wahrheit in diesem Sinne verpflichtet fühlen.

Dein Ulrich

Zur Ausbreitung der Corona-Infektionen: Wachstumsmodelle

Die Corona-Krise, ihre Bewertung und die Maßnahmen zu ihrer Bewältigung sind seit Wochen das alles beherrschende Thema in den Medien. Dabei kommt neben den medizinischen, biologischen, wirtschaftlichen, gesellschaftlichen, rechtlichen und ethischen Fragen, die das Virus aufwirft, auch die Mathematik ins Spiel. Es sind mehrere Themenkomplexe, bei denen die Mathematik gefragt ist und adressiert wird: bei der Statistik der Datenerfassung und –auswertung, bei der Modellierung der Ausbreitung und der Ausbreitungsgeschwindigkeit der Infektionen, aber auch bei der Modellierung der wirtschaftlichen Auswirkungen des Shutdowns. Ferner spielen u.a. Methoden des Maschinellen Lernens bei der Suche nach einem Impfstoff oder nach Medikamenten eine wesentliche Rolle.

Wir wollen hier nur den Komplex der Ausbreitung der Infektionen ansprechen. In den Medien spielt dabei das Modell des exponentiellen Wachstums eine besondere Rolle. Außer von Virologen und Epidemiologen hören wir es von Vertretern aller Medien und von Politikern. Mathematiker kommen in der Öffentlichkeit kurioserweise kaum oder eher am Rande zu Wort.

Zur Charakterisierung der Ausbreitung der Infektionen werden in den Medien eine Vielzahl von Kurven gezeigt, oft erstaunlich nichtssagende Kurven, deren Sinn von Laien nicht und Experten nur mit Mühe verstanden werden können. Manche der Kurven werden in einem Achsenkreuz gezeigt, ohne dass die Achsen bezeichnet oder erläutert würden, so dass nicht klar wird, was die Kurven eigentlich veranschaulichen.

Zum Beispiel wurden in der anfänglichen Berichterstattung in den Medien zur Erklärung, warum eine Verlangsamung der Virus-Ausbreitung (durch Isolierung, Kontaktreduktion, soziale Distanzierung) medizinisch sinnvoll und notwendig ist, oft jeweils zwei Kurven gezeigt, deren Form an „Normalverteilungen“ aus der Statistik erinnern (eine spitze und eine flache Kurve). Zu diesen Kurven wird erklärt, dass sie einerseits die schnelle, ungebremste Ausbreitung (die spitze Kurve) und andererseits eine systematisch verlangsamte, zeitlich gedehnte Ausbreitung der Infektionen (die flache Kurve) beschreiben. Dabei soll eine waagerechte Linie, unter der die flache Kurve verläuft, die Kapazitätsgrenze für Intensivbehandlungen in deutschen Krankenhäusern charakterisieren. Diese Kurven haben aber keine präzise bezeichnete mathematische Bedeutung, sondern eher symbolischen Charakter.

Um etwas mehr Klarheit in die Vielfalt der Darstellungen zu bringen, wollen wir hier ein paar allgemeine Worte über „mathematische Wachstumsmodelle“ sagen. Dabei wenden wir uns ganz bewusst an den mathematisch nicht besonders versierten oder interessierten Leser.

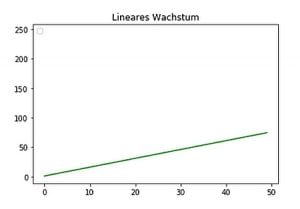

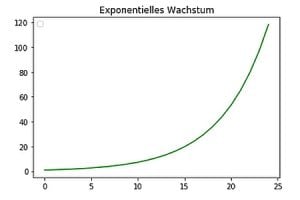

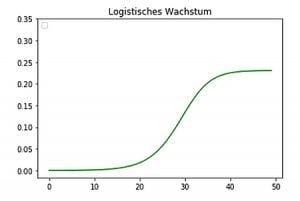

Die drei wichtigsten Wachstumsmodelle sind das lineare, das exponentielle und das logistische Modell. Um sich einen Eindruck, eine Idee dieser drei Modelle zu verschaffen, braucht man nur einen Blick auf die Form der zugehörigen Wachstumskurven zu werfen:

Von diesen drei Modellen ist das lineare Wachstumsmodell das einfachste und alltäglichste. Trotzdem gehen wir hier zunächst auf das Modell des exponentiellen Wachstums ein, weil von diesem seit dem Beginn der Corona-Krise in den Medien fast ausschließlich die Rede ist.

Exponentielles Wachstum ist eigentlich leicht zu verstehen: Wenn sich z.B. irgendeine Menge täglich verdoppelt, dann haben wir es mit exponentiellem Wachstum im engsten Sinne zu tun. Sich vorstellen kann man das ja sofort. Verblüffend ist aber, wie schnell die Menge nach einer eher ruhigen Startphase anwächst.

Veranschaulicht wird dieses Anwachsen gern durch die indische Legende vom Schachbrett mir den Reiskörnern. Bei Verdoppelung der Anzahl der Reiskörner von einem Feld des Schachbretts zum nächsten sieht das Wachstum am Anfang harmlos aus. Aber am Ende, nachdem alle 64 Felder belegt sind, übersteigt die Menge der Körner alle Vorstellungen. Allein auf dem letzten Feld müssten die Reisernten der ganzen Welt von vielen hundert Jahren untergebracht werden.

Eine andere Geschichte, das Gleichnis vom Lilienteich, soll die Bedrohlichkeit des exponentiellen Wachstum deutlich machen: In einem Teich wächst eine Linie täglich auf die doppelte Größe an. In den ersten Tagen ist die Ausbreitung scheinbar völlig bedeutungslos, so geht es weiter, und auch am 29.Tag ist „nur“ der halbe See von Lilien bedeckt. Aber dann, am 30. Tag, ist der See vollständig zugewachsen, und alles Leben im See erstickt…

Nun muss es bei exponentiellem Wachstum nicht eine tägliche Verdoppelung der betreffenden Menge sein, es kann auch ein anderer Zeitraum sein, der zu einer Verdoppelung führt, z.B. eine Verdoppelung alle 4 Tage oder alle 10 Tage.

Nur am Rande sei erwähnt, dass wir es z.B. bei der Zinsesverzinsung von Kapital (wenn die Zinsen nicht abgeschöpft, sondern dem Kapital hinzugefügt werden) ebenfalls mit exponentiellem Wachstum zu tun haben: Bei einem Jahreszinssatz von zum Beispiel 5 % würde sich das Kapital bei Zinsesverzinsung ungefähr alle 14 Jahre verdoppeln.

Die Situation verändert sich aber grundlegend, wenn der Zeitraum, in dem die Verdoppelung stattfindet, nicht konstant ist, sondern sich laufend verändert. Wenn also z.B. der Verdoppelungszeitraum erst 4 Tage, dann – nach einigen Wochen – nur noch 6 Tage, dann – noch einige Wochen später – vielleicht nur noch 10 Tage beträgt usw.

In einem solchen Fall, wenn der Zeitraum, in dem die Verdoppelung stattfindet, sich dauernd verändert (vergrößert), haben wir es nicht mehr mit exponentiellem Wachstum im engeren Sinne zu tun, sondern mit einem möglicherweise deutlich komplizierteren Anwachsen. Über einen größeren Zeitraum betrachtet, sieht das Wachstum dann vielleicht eher wie lineares Wachstum aus. Konkret: Wenn sich der Zeitraum, in dem die Verdoppelung stattfindet, ebenfalls verdoppelt, also von 4 auf 8 Tage, dann auf 16, danach auf 32 Tage usw. anwächst – dann ist das global gesehen kein exponentielles, sondern lineares Wachstum.

Lineares Wachstum lässt sich schnell abhandeln: Es wird durch eine gerade Linie charakterisiert. Es ist das uns vertrauteste Wachstumsmodell: Der Preis einer Ware steigt in der Regel linear mit der Menge der Ware, der Arbeitslohn sollte linear mit dem Zeitraum anwachsen, in dem die Arbeit ausgeübt wird usw. Bei allem, was wir in der Schule und im Alltag mit dem Dreisatz-Prinzip ausgerechnet haben und ausrechnen können, haben wir es mit linearen Beziehungen, mit linearem Wachstum zu tun.

Logistisches Wachstum als alternatives Modell zu exponentiellem Wachstum

Wie im Beispiel der Schachbrettlegende wächst unbegrenzt exponentielles Wachstum schließlich dramatisch schnell an, es geht sehr schnell ins quasi „Unendliche“.

In der Wirklichkeit ist exponentielles Wachstum aber nur theoretisch unbegrenzt, es geht praktisch eigentlich immer in eine andere Form des Wachstums über. Neben dem gerade behandelten einfachen linearen Wachstum ist ein sehr wichtiges, besonders realistisches Wachstumsmodell das logistische Wachstum.

Die obige Kurve zum logistischen Wachstum zeigt (von links nach rechts) das Charakteristische des logistischen Wachstums: Zu Beginn, in der Startphase, verhält sich die Kurve wie beim exponentiellen Wachstum, ändert dann aber – an einem „Wendepunkt“ – ihre Richtung, wird flacher und nähert sich immer mehr einer waagerechten Geraden an. Das Wachstum wird durch diese Gerade begrenzt. In der Realität ist der Übergang vom exponentiellen Wachstum in begrenztes Wachstum in aller Regel dadurch bedingt, dass Ressourcen beschränkt sind und aufgebraucht werden…

Auch auf die Corona-Ausbreitung bezogen, haben wir es langfristig mit logistischem Wachstum zu tun: Wenn die senkrechte Achse die Gesamtzahl aller Infizierten (einschließlich der bereits Genesenen) beschreibt, ist klar, dass weitere Infektionen spätestens dann ausgeschlossen sind, wenn alle Individuen infiziert sind oder waren (und eine zwei- oder mehrmalige Infektion ausgeschlossen ist). Nach den Erkenntnissen der Epidemiologie ist sogar zu erwarten, dass eine solche Begrenzung praktisch schon erreicht wird, wenn etwa 70% der Individuen infiziert sind oder waren. (Man spricht dann auch von „Herdenimmunität“.)

Die derzeitigen Maßnahmen zur Kontaktminimierung (im April 2020) zielen dagegen darauf ab, zu erreichen, dass die sogenannte Reproduktionszahl R (möglichst deutlich) kleiner als 1 ist, das heißt dass jedes Infizierte Individuum im Mittel (möglichst deutlich) weniger als ein weiteres Individuum mit dem Virus infiziert. . Wenn das gelingt, wird die Gesamtzahl der gleichzeitig Infizierten auf Dauer (deutlich) abnehmen. Wenn man die Reprodukionszahl R, ihre zeitliche Entwicklung und die dadurch bedingte Ausbreitung der Infektion durch Kurven veranschaulicht, haben diese Kurven eine andere Bedeutung als die oben diskutierten Kurven und Modelle, weil sich R nicht auf die Gesamtzahl der Infizierten, sondern nur auf die jeweils aktuell Infizierten (ohne die bereits Genesenen und Verstorbenen) bezieht. Selbst in solchen Fällen, bei denen die in den Medien präsentierten Kurven eine mehr oder weniger präzise Bedeutung haben, muss man also genau hinsehen und bei der Interpretation der Kurven vorsichtig sein.

Resumee

Für die Ausbreitung der Corona-Infektion ist also das exponentielle Modell immer nur kurzfristig oder für eine bestimmte Zeitspanne relevant: die Wachstumsraten ändern sich, insbesondere als Folge der getroffenen Maßnahmen, von Tag zu Tag. Global, auf lange Sicht gesehen, wird das Wachstum in ein logistisches Wachstum übergehen. Die getroffenen Maßnahmen zielen jedenfalls darauf ab, dass sich ein exponentielles Wachstum (z.B. in einer „zweiten Welle“) keinesfalls wieder einstellt.

Viele Fragen zum Corona-Virus, u. a. zu seiner Übertragbarkeit, zu seiner Gefährlichkeit, zu seiner Ausbreitungsdynamik, zu seiner Bekämpfung sind heute noch nicht oder nicht vollständig geklärt, und auch anerkannte Experten äußern sich nicht einheitlich über diese Fragen. Insbesondere die Corona-Datenerfassung ist unübersichtlich und uneinheitlich. Über die Gesamtzahl der Infizierten (die „Dunkelziffer“) wird viel spekuliert. Die zugehörige Statistik ist infolgedessen unsicher und oft fragwürdig. Im Hinblick auf die Aufklärung der Öffentlichkeit ist es umso wichtiger, dass das, was man sicher weiß, über die Medien klar und unmissverständlich kommuniziert und veranschaulicht wird, und möglichst nur das.

Zur Corona-Krise: Ist „Herdenimmunität“ ein realistisches Ziel?

Die Corona-Krise ist seit Wochen das beherrschende Thema in den Medien. Dabei kommt neben den medizinischen, biologischen, wirtschaftlichen, gesellschaftlichen, rechtlichen und ethischen Fragen, die das Virus aufwirft, auch die Mathematik ins Spiel. Es sind mehrere Themenkomplexe, bei denen die Mathematik gefragt ist und adressiert wird: bei der Statistik der Datenerfassung und –auswertung , bei der Modellierung der Ausbreitung und der Ausbreitungsgeschwindigkeit der Infektionen, aber auch bei der Modellierung der wirtschaftlichen Auswirkungen des Shutdowns. Daneben können z.B. Methoden des Maschinellen Lernens bei der Suche nach einem Impfstoff oder nach Medikamenten genutzt werden.

Schon seit einigen Wochen werden in den offiziellen Verlautbarungen der Politik und der virologischen Experten im Wesentlichen zwei grundsätzliche Ziele und Strategien zur Überwindung der Krise genannt:

- Die Abflachung der Kurve der Corona-Infizierten insbesondere durch Isolierungsmaßnahmen. Damit soll erreicht werden, dass die Zahl der gleichzeitigen schweren Krankheitsverläufe jeweils (möglichst deutlich) unter der Gesamtkapazität der Intensivstationen der deutschen Krankenhäuser bleibt. Dadurch soll sichergestellt werden, dass es zu keiner Zeit zu Behandlungsengpässen in Krankenhäusern kommt und jeder Patient adäquat versorgt werden kann.

- Die „Durchseuchung“ der Gesamtbevölkerung zu etwa 70% mit der Corona-Infektion. Dabei gehen die Virologen davon aus, dass eine ca. „70%-Durchseuchung“ zu einer weitgehenden Immunität in der Bevölkerung („Herdenimmunität“) führen würde.In den ersten offiziellen Stellungnahmen, kurz nach Ausbruch der Krise, ist dieses Ziel noch als durchaus erstrebenswert vertreten worden, u.a. von der Kanzlerin.

Offensichtlich – schon aus elementarmathematischen Gründen - vertragen sich diese beiden Ziele nicht gut mit einander: Während das Ziel 1 auf eine Minimierung der gleichzeitigen Infektionenund damit auf eine zeitliche Streckung herausläuft, würde man das Ziel 2 „im Prinzip“ möglichst bald erreichen wollen, um damit die Krise zu überwinden. Praktisch kann man das Ziel 2 natürlich nicht auf Kosten der unkontrollierten Zunahme schwerer Krankheitsverläufe verfolgen.

Wenn man andererseits versuchen würde, beide Ziele miteinander zu kombinieren, müsste man eine sehr lange Zeit mit der Krise und entsprechenden Maßnahmen leben. Insofern bleibt nur die Hoffnung auf ein Medikament und auf einen Impfstoff.

Künstliche Intelligenz III: Zukunft gestalten, Werte erhalten

Die rasante Entwicklung der Künstlichen Intelligenz (KI) wirkt sich auch in Deutschland auf alle Lebens- und Arbeitsbereiche aus – und wirft die Frage auf, wie sich der Wandel vorteilhaft und verantwortungsvoll zugleich gestalten lässt. Folge vier unserer Digitalserie liefert Antworten.

In der Diskussion über rechtliche und ethische Aspekte von KI vermischen sich berechtigte Anliegen mit unbegründeten Ängsten. Berechtigt sind zum Beispiel Fragen nach Sicherheitsvorkehrungen und Kontrollmechanismen, wenn KI-Algorithmen lebenswichtige Entscheidungen treffen, etwa im juristischen Bereich oder in der medizinischen Diagnostik. Wie schwer eine klare Antwort auf die Frage fällt, wer im Einzelfall die Verantwortung für fatale Entscheidungen übernehmen soll, wird in der Debatte über das autonome Fahren deutlich. Jeder kann sich eine Situation vorstellen, in der sich ein Unfall nicht mehr vermeiden lässt und das autonome Fahrzeug in Bruchteilen von Sekunden über das Leben

und den Tod von Verkehrsteilnehmern entscheiden muss. Nach welchen Prinzipien sollen solche Entscheidungen fallen? Eine verbindliche Antwort ist bislang nicht gefunden.

Eigene Daten schützen

Auch die Sorge um den Datenschutz und die Privatsphäre ist verständlich. Im Prinzip aber bilden in Deutschland das Grundgesetz, Gesetze und die Datenschutzgrundverordnung der EU einen sinnvollen, für die digitale Welt gültigen Rechtsrahmen. Gefährlich ist eher ein leichtfertiger Umgang von Nutzern mit ihren eigenen Daten. Und was ist von Prognosen zu halten, die für die fernere Zukunft die Weltherrschaft superintelligenter Maschinen voraussagen? Alle KI-Systeme lösen ausschließlich spezielle Aufgaben. Aber die Systeme selbst sind Maschinen oder Algorithmen. Sie haben keine Gefühle und kein Bewusstsein, sondern verfolgen nur Ziele, für die sie programmiert sind. Roboter, die nicht nur

Einzelaufgaben lösen, sondern der menschlichen Intelligenz in ihrer Breite nahekommen, sind auch für die nächsten Jahrzehnte eine Illusion.

Deutschlands Stärken nutzen

Oft ist von der Dominanz der vier US-amerikanischen Internet-Giganten Google, Facebook, Amazon und Apple die Rede. In den Hintergrund treten dabei die guten Voraussetzungen, die Deutschland durch seine Verbindung aus klassischem Ingenieurwissen, theoretischer Fundierung und hoher KI-Forschungskompetenz hat. "Wenn wir die neuen Möglichkeiten der KI mit den klassischen Stärken unserer Unternehmen kombinieren, können wir neue Chancen im internationalen Wettbewerb schaffen und den digitalen Wandel nach unseren Wertvorstellungen gestalten", sagt Professor Stefan Wrobel, einer der prägenden KI-Experten in Deutschland.

In der Tat hat KI das Potenzial, die Lebensqualität zu verbessern und der Menschheit bei der Überwindung von Krankheiten, Armut und Ungleichheit zu helfen. Ein solcher Fortschritt setzt Gestaltungswillen und politische Digitalkompetenz zwingend voraus. Die Politik darf die KI-technologischen Entwicklungen nicht einfach nur laufen lassen, sondern muss sie im Dialog mit führenden Experten fördern und gestalten. Andernfalls wird sie ihrer Verantwortung nicht gerecht.

Der dramatischste Nachholbedarf besteht jedoch im Bereich der digitalen Aufklärung und Bildung. Und da geht es nicht in erster Linie um die Ausstattung aller Schüler mit einem Tabletcomputer, sondern um die digitalen Kerninhalte des Unterrichts. Ohne diese Inhalte und ein Grundverständnis für algorithmische Prinzipien bleiben Medienkompetenz und

digitale Bildung substanzlos.

Künstliche Intelligenz II: Aufs Lernen für die Praxis programmiert

Unter den Methoden, die bei der Künstlichen Intelligenz (KI) in der Praxis eingesetzt werden, spielt das "maschinelle Lernen" (ML) eine zunehmend wichtige Rolle. Den Kern von ML bilden sogenannte "lernende Algorithmen". Ihre Funktion beleuchtet – in der zweiten KI-Folge – der dritte Teil unserer Digitalserie.

Algorithmen sind aus unserem modernen Leben nicht mehr wegzudenken. Sie steuern sämtliche digitalen Prozesse und Geräte und liegen jedem Computerprogramm zugrunde. In ihrer klassischen Form umfassen sie eine Folge von Anweisungen und bestehen aus vielen genau definierten Einzelschritten.

"Maschinelles Lernen" (ML) wiederum basiert auf lernenden Algorithmen. Diese Algorithmen berechnen – anders als herkömmliche, regelbasierte Algorithmen – ein Ergebnis nicht einfach durch Abarbeiten einer Folge von Befehlen. Vielmehr durchlaufen sie zunächst eine "Trainingsphase". Dabei werden interne Zahlenwerte durch das Verarbeiten einer großen, oft riesigen Menge von Beispieldaten so verändert, dass der Algorithmus Muster einübt, neue Merkmale erkennt und sich seine Funktionsweise und damit auch seine Ergebnisse schrittweise verbessern. Man sagt, das System wird "trainiert", oder eben auch, der Algorithmus lernt.

Viele Einsatzbereiche

Verglichen mit dem menschlichen Lernen ist das maschinelle Lernen ein aufwändiger Prozess: Ein Kind lernt anhand weniger Beispiele, einen Hund von einer Katze und einen Apfel von einer Birne zu unterscheiden. Ein Algorithmus braucht dagegen in der Regel sehr viele Trainingsbeispiele, bis er ausschlaggebende Merkmale (Muster) erkannt hat und die

Unterscheidung sicher beherrscht.

Dafür sind aber die Anwendungsmöglichkeiten geradezu unbegrenzt: ML-Systeme werden trainiert, um Handschriften zu lesen, gesprochene Sprache zu verstehen und zu übersetzen, Spam-Mails auszusortieren und bei medizinischen Diagnosen krankes Gewebe zu identifizieren. Außerdem lernen sie, beim assistierten Fahren Verkehrsschilder

und Spurlinien zu erkennen, anspruchsvolle Spiele zu gewinnen, passende Partner zu vermitteln, Stimmungen in Gesichtern zu erkennen und im Internet Hass-Mails und Fake News zu identifizieren und auszusondern.

Zum Einsatz kommt ML-Software heute bereits auch bei der Bewertung der Kreditwürdigkeit von Bankkunden, der Festlegung von Versicherungskonditionen, der Vorauswahl in Bewerbungsverfahren und im Börsenhandel. Und wenn wir im Internet lesen "Das könnte Sie auch interessieren ..." , also bei personalisierten Kaufempfehlungen, ist ML im Spiel, ebenso wie bei Routenplanern, Sprachassistenten wie Alexa, Cortana, Siri, Google Assistant und vielen weiteren Apps, die täglich weltweit von vielen Millionen Menschen benutzt werden.

Die Liste solcher Anwendungen ließe sich beliebig fortsetzen, und ständig kommen neue hinzu. Bei manchen dieser Anwendungen funktioniert das Lernen schon sehr gut, bei anderen sind die Lernergebnisse noch stark verbesserungsbedürftig. Aber der Trend ist klar: Bei immer mehr Anwendungen werden immer überzeugendere Ergebnisse erzielt.

Wenn ML-Systeme Entscheidungen treffen, können Menschen davon unmittelbar betroffen sein. Wie kann man sicherstellen, dass solche "ML-Entscheidungen" kontrolliert und eventuell korrigiert werden können? Auf solche Fragen und die rechtlichen, gesellschaftlichen und ethischen Aspekte von Künstlicher Intelligenz geht die nächste Folge ein.

Künstliche Intelligenz I: Von Menschen für Menschen geschaffen

Der Begriff ist sperrig, hat aber Potenzial, das Wort des Jahres zu werden: "Künstliche Intelligenz" ist in aller Munde. In drei Teilen der neuen Digitalserie beleuchtet prisma die praktischen Anwendungen, Perspektiven und auch Grenzen von KI.

Täglich wird in den Medien über "Künstliche Intelligenz" (KI) berichtet. Im Sommer 2018 unterhielt sich Bundeskanzlerin Angela Merkel auf einer Digital-Konferenz in Berlin mit "Sophia", einem mit KI ausgestatteten Roboter. Das Wissenschaftsjahr 2019 ist KI gewidmet. Das alles macht deutlich: Längst ist das Thema nicht mehr Science-Fiction,

sondern in der Gegenwart angekommen.

Und in der Tat: Die Anwendungsgebiete von KI sind enorm und reichen bereits heute von der Bild-, Gesichts- und Handschrifterkennung über die Sprachverarbeitung und das automatische Übersetzen von Texten bis zu automatisierten Diagnoseverfahren in der Medizin. KI und Algorithmen des sogenannten maschinellen Lernens spielen insbesondere bei den immer ausgefeilteren Fahrassistenten für Autos eine entscheidende Rolle – bis hin zum schließlich autonom fahrenden Auto.

Im Alltag angekommen

Allerdings fehlt eine einheitliche Definition von KI. Experten sprechen von KI, wenn ein technisches System – ein Roboter, ein Computer, ein Algorithmus – sich "intelligent" im Sinne menschlicher Intelligenz verhält. Eine präzise Beschreibung ist das aber nicht, weil die menschliche Intelligenz viele verschiedene Facetten hat – neben den kognitiven auch emotionale und soziale Komponenten. Ein vom Mathematiker Alan Turing im Jahre 1950 konzipiertes Gedankenexperiment, der sogenannte "Turing-Test", liefert bis heute einen Maßstab für die Nähe zwischen KI und menschlicher Intelligenz. Demnach hat ein KI-System den Test bestanden, wenn man dem System beliebige Aufgaben stellen kann und aus den Lösungen nicht geschlossen werden kann, ob man es mit künstlicher oder menschlicher Intelligenz zu tun hat.

KI ist seit Mitte des vorigen Jahrhunderts Gegenstand der Forschung und Entwicklung. In Deutschland gehört das 1988 gegründete "Deutsche Forschungszentrum für Künstliche Intelligenz" zu den Pionieren. Entscheidend für die enormen Erfolge mit KI in den letzten 20 Jahren war die enorme Leistungssteigerung von Computern. Heute rechnet bereits ein

Smartphone ungefähr so rasant wie der schnellste Computer der Welt vor 30 Jahren – und die Menge verfügbarer Daten wächst weltweit geradezu explosionsartig.

KI ist im Alltag angekommen und unterstützt uns – oft unbemerkt – in vielen Lebensbereichen. Längerfristig sollten KI-Systeme dem Menschen alle uninteressanten und gefährlichen Arbeiten abnehmen und ihm die Möglichkeit geben, sich kreativen Tätigkeiten zu widmen. Gleichzeitig verlangen die mit KI-Systemen verbundenen rechtlichen und ethischen Fragen nach Antworten, aus denen Leitlinien für den zukünftigen Umgang mit KI hervorgehen sollten. Grundsätzlich steht fest: Die KI-Entwicklung liegt in der Hand von Menschen, KI-Systeme sind Programme oder Maschinen – sie entwickeln sich nicht von selbst oder aus eigener Initiative.

Algorithmen III: Intelligente Maschinen, böse Roboter

In Teil 1 und 2 unserer prisma-Serie haben wir uns dem Thema der Algorithmen ganz allgemein genähert. Die kontrovers diskutierte Frage, der wir uns im dritten und letzten Teil widmen wollen, lautet: Wohin führen uns Algorithmen, die Muster und Strukturen selbstständig erkennen, sich anpassen und verändern und ihrerseits neue Algorithmen entwickeln können?

Die Einschätzungen, auf die fernere Zukunft bezogen, reichen von phantastischen Perspektiven mit intelligenten Maschinen und Robotern, die für uns Menschen alles Unangenehme erledigen, bis hin zu düsteren Aussichten einer Beherrschung der Menschen durch sich selbstständig und unkontrollierbar weiterentwickelnde Maschinen. So weit sind wir allerdings noch lange nicht. Um zu einer realistischen Einschätzung zu kommen, schauen wir uns deshalb an, was heute schon möglich ist. Aktuelle Algorithmen des Maschinellen Lernens (ML) werden zum Beispiel zur Gesichts- und Spracherkennung eingesetzt.

Nehmen wir als leicht verständliches Beispiel die Unterscheidung weiblich/männlich bei der Gesichtserkennung. Als man dafür noch keine der neuen ML-Methoden verwendete, musste man im Algorithmus festlegen (einprogrammieren), anhand welcher charakteristischen Daten und biometrischen Werte die Unterscheidung vorgenommen werden sollte. Beim Maschinellen Lernen aber findet der Algorithmus anhand einer Fülle von Beispielen diese Kriterien selbst. Mit Millionen von Beispielen wird der Algorithmus trainiert. Nach dieser Trainingsphase trifft er die Unterscheidung dann selbst.

Neuronale Netze

Solche selbstlernenden Algorithmen sind Gegenstand der Forschung und Entwicklung in einer riesigen Fülle von Anwendungen in Technik, Biologie, Medizin und Wirtschaft. Bezogen auf Gesichter versuchen sie etwa, menschliche Stimmungen zu erkennen und Persönlichkeitsmerkmale zu erfassen – und angesichts des geradezu unbegrenzten Trainingsmaterials aus dem Internet sind die Analysemöglichkeiten atemberaubend. Bei einer aktuellen Methode des Maschinellen Lernens (beim "Deep Learning") werden dazu spezielle "neuronale Netze" benutzt, die durch eine große Anzahl von Beispielen trainiert werden und sich im Laufe des Trainingsprozesses so verändern und anpassen, dass schließlich (fast) alle vorgelegten Aufgaben selbstständig richtig gelöst werden.

Die Bezeichnung "neuronale Netze" deutet zwar auf eine Verwandtschaft mit dem Gehirn hin – tatsächlich handelt es sich aber um eine statistische Methode, die durch einfache Modelle biologischer Neuronen inspiriert wurde. Sind mit diesen atemberaubenden Perspektiven aber nicht auch die Möglichkeiten der Kontrolle und des Eindringens in die Privatsphäre atemberaubend beängstigend? Und wenn man nicht nur Gesichter in dieser Weise interpretiert, sondern die viel umfassenderen Informationen des Internets über seine Nutzer in die Analyse mit einbezieht? Und für gefilterte Informationen oder sogar für Entscheidungen (über Kreditvergabe oder Stellenbesetzungen) verwendet, die weit über Systeme wohlmeinender Empfehlungen hinausgehen? Dass totalitäre politische Systeme die umfassenden Kenntnisse und Einblicke in die Privatsphäre der Nutzer missbrauchen und sich der Kontroll- und Beeinflussungsmöglichkeiten zu bedienen versuchen, ist zwar naheliegend, aber nicht akzeptabel. Politische Systeme, für die Grund rechte, Persönlichkeitsrechte und der Schutz der Privatsphäre konstitutiv und fundamental sind, müssen und können die technischen und algorithmischen Entwicklungen und deren Anwendungen so begrenzen, dass diese Rechte nicht verletzt werden.

Sicherheit und Freiheit

Die Politik muss auch hier die richtige Balance finden zwischen Sicherheit und angemessener, begrenzter Überwachung auf der einen und Freiheit und Schutz der Privatsphäre auf der anderen Seite – und durch eine adäquate Gesetzgebung gestalten. Doch dazu müssen die Politik, das Parlament und die Rechtsprechung die digitalen, algorithmischen Entwicklungen und Gefährdungen verstehen – nicht im Detail, aber im Prinzip.

Bloß: Wie kann dieses Verständnis erreicht werden? Es besteht immer die Gefahr, dass die Politik und die Gesetzgebung zu spät kommen und den technologischen Entwicklungen hinterherlaufen. Der Dialog zwischen Politikern und Technologen ist in Bezug auf die digitale Entwicklung beides: äußerst wichtig und äußerst mühsam. Alle Parteien, viele Politiker reden über die "Digitalisierung". Aber wissen sie, was sie damit meinen? Nach Jahren ernüchternder Bemühungen, die Politik zu beraten, halten viele Experten die algorithmische Aufklärung der politischen Instanzen, der Medien und der allgemeinen Öffentlichkeit für überaus dringend und überfällig.

Und diese Aufklärung muss, womit wir wieder bei unserem Einstiegsbeispiel vom kleinen Einmaleins wären, in der Schule anfangen: Zur Medienkompetenz der Schülerinnen und Schüler gehören Basiskenntnisse über die technologischen Grundlagen des Digitalen und ein fundiertes Verständnis für die Möglichkeiten und Grenzen, Chancen und Gefahren der aktuellen algorithmischen Entwicklungen, insbesondere im Bereich der Künstlichen Intelligenz.

Algorithmen II: Auf dem Weg zur künstlichen Intelligenz

In der vergangenen Woche haben wir uns ganz allgemein mit Algorithmen beschäftigt. Doch wie werden Algorithmen konstruiert? Wie sind sie aufgebaut? Das wollen wir an Hand von zwei Anwendungen erläutern und in Teil 2 unserer prisma-Serie deutlich machen, dass man sich algorithmisches Verständnis und eine algorithmische Denkweise recht einfach zu eigen machen kann.

Ein praktisches Beispiel für die Arbeit von Algorithmen ist das Sortieren. Jeder Mensch hat eine intuitive Vorstellung davon, wie Objekte sortiert werden können, seien es Spielkarten, Namen oder Zahlen. Wir stellen jetzt unserem Computer die Aufgabe, die Bücher in einem Regal alphabetisch nach Autorennamen zu sortieren. Klingt einfach. Ist es eigentlich auch.

Dazu brauchen wir einen Algorithmus. Als Erstes muss der beim Vergleich von zwei Namen entscheiden können, welcher Name vor dem anderen platziert wird. Dann können wir wie folgt verfahren: Wir fangen vorne an, vergleichen den ersten mit dem zweiten Namen, ordnen sie alphabetisch, vergleichen dann den (eventuell neuen) zweiten mit dem dritten Namen, ordnen sie alphabetisch, vergleichen den (eventuell neuen) dritten mit dem vierten und fahren so fort, bis wir das Ende der Liste erreicht haben.

Die neue Liste ist nun noch nicht vollständig alphabetisch, aber wir stellen fest, dass der letzte Name wirklich der alphabetisch gesehen letzte ist. Dass das so sein muss, ist eine kleine Denksportaufgabe: Wem diese Überlegung zu mühsam ist, der probiert es einfach aus – etwa mit Namenskärtchen oder Spielkarten. Nun muss der Algorithmus mit der Liste wieder vorne anfangen. Er vergleicht und sortiert den ersten und den zweiten Namen, den zweiten und den dritten und so weiter, bis er am vorletzten Namen angekommen ist: Der ist dann auch der vorletzte im Alphabet – mit der gleichen Überlegung wie oben. Im dritten Durchlauf ergibt sich dann als drittletzter Name der alphabetisch richtige. Und so geht es weiter, Durchlauf für Durchlauf, bis am Ende nur noch der erste mit dem zweiten Namen verglichen und eventuell vertauscht wird. Damit ist der Algorithmus beendet – und die Liste ist vollständig sortiert.

Googles berühmter “PageRank”

Die Erfahrung zeigt, dass Schüler diesen Algorithmus (in der Informatik als “Bubblesort” bekannt) schon in der Grundschule verstehen können und dass ihn meist einige von ihnen sogar selbst “erfinden”. In der Praxis aber spielt er keine große Rolle, weil es bessere, schnellere Algorithmen für die gleiche Aufgabe gibt. Bubblesort ist aber geeignet, eine Ahnung von der algorithmischen Denkweise zu vermitteln, und lässt sich mit einer Programmiersprache in wenigen Zeilen programmieren.

Ein weiteres Beispiel für einen Algorithmus ist der sogenannte “PageRank”. Gibt man bei Goo gle einen Begriff ein, sortiert der “Google-Algorithmus” die Seiten, die für diesen Begriff von Bedeutung sind. Doch wie wird die Reihenfolge der Suchergebnisse festgelegt? Natürlich kennen wir den “Page Rank”- Algorithmus nicht in all seinen Details, er ist ein von Google wohlgehütetes Betriebsgeheimnis. Aber einiges ist bekannt und plausibel – so plausibel, dass man durchaus selbst darauf kommen kann.

Zunächst ist plausibel, dass eine Seite umso wichtiger ist, je mehr andere Seiten auf sie verweisen, mit anderen Worten: Die Anzahl der “In-Links” ist wesentlich. Nun sind aber sicher nicht alle In-Links gleich wichtig, sondern wiederum sind die “Links” als wichtiger zu bewerten, die ihrerseits von einer “wichtigen” Seite ausgehen. Hier kommt etwas ins Spiel, das die Informatiker “Rekursion” nennen, wodurch die Angelegenheit unübersichtlich zu werden scheint: Die Wichtigkeiten hängen voneinander ab – und werden von den Wichtigkeiten einer möglicherweise riesigen Anzahl vernetzter Seiten mitbestimmt. Macht man sich klar, dass es mittlerweile viele Milliarden von in Frage kommenden Seiten gibt, kann man sich vorstellen, dass man es mit einem extrem großen System von bewerteten Links zu tun hat. Mit diesem System, das sich zudem wegen der Dynamik des Internets dauernd verändert, muss ein brauchbarer Algorithmus fertig werden.

Auch Algorithmen können lernen

Die Annahmen, die wir hier gemacht haben, sind stark vereinfacht. Die tatsächlichen Algorithmen berücksichtigen eine Vielzahl (Hunderte) weiterer Bedingungen (“Parameter”). Schließlich – und das ist faszinierend und in seinen Auswirkungen zugleich vielleicht nicht unbedenklich – berücksichtigen sie die Vorgeschichte, das individuelle Suchverhalten – und damit die Gewohnheiten und die vermuteten Interessen des Nutzers. Mit diesem Element der Individualisierung, das wir von der – vielleicht oft nützlichen, aber manchmal auch nervigen – Empfehlungsformulierung “Das könnte Sie auch interessieren …” kennen, gehört der entsprechend erweiterte PageRank-Algorithmus zu den sich anpassenden, “selbstlernenden” Algorithmen.